本系列生成式人工智能导论博文基于国立台湾大学李宏毅老师发布的课程视频整理而来, 仅用作复习参考.

可以算是人工智能领域的入门课程.

需要明确的是, 李宏毅老师上传的课程已经是2024年的课程, 距今有两年的时间, 知识难免有过时的可能, 如果出现了这种情况, 博主会尽可能补足当前的状态.

生成式人工智能导论 Chap.2 训练我自己

2.1 添加能增强输出的Prompt

上一次提及到模型的输入(Prompt), 在此前的研究中, 曾提及到有一些能够显著提高模型思考能力的Prompt, 最典型的叫做 模型思考(CoT, Chain of Thought) .

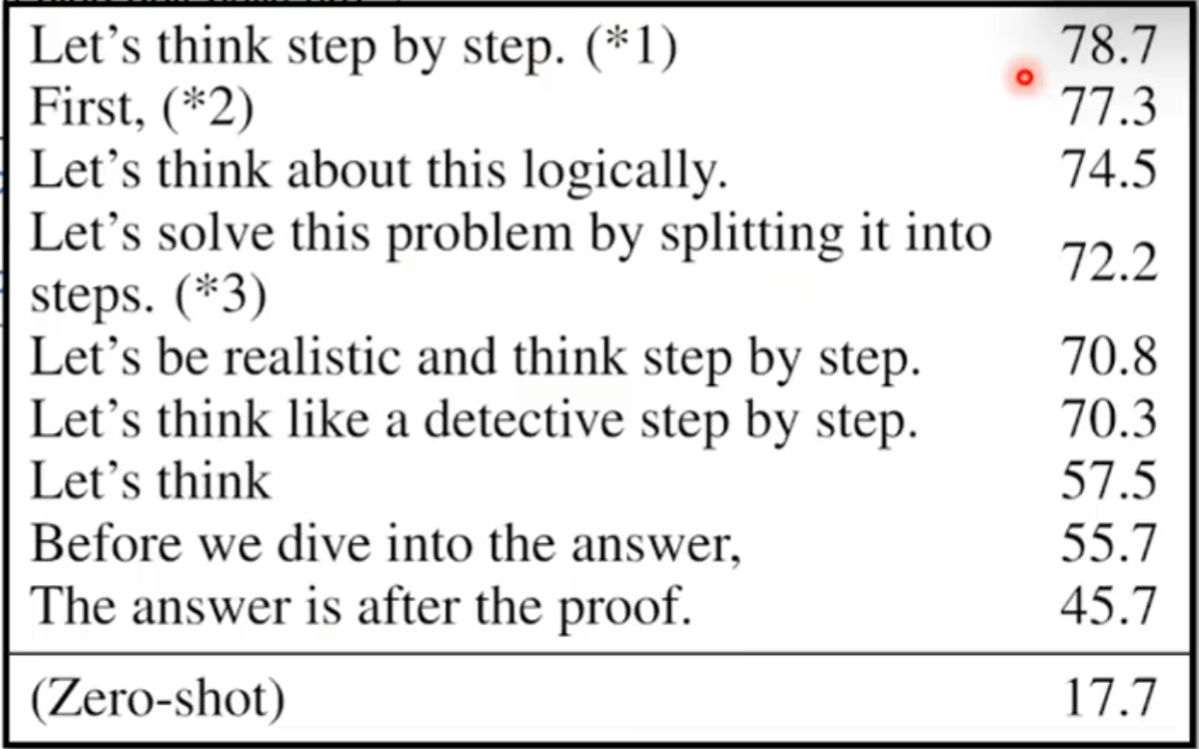

在2022年的一篇论文中提出了, 如果在模型的输入中加入一些 鼓励模型进行思考 的话语, 则模型在解决数学问题时的正确率会大幅提升.

在2025年, CoT的这个结论仍然有效, 类似于 Let’s think step by step 的提示词仍然能在很多情况下起到良好的促进作用. 同时, 基于CoT也衍生出了很多更先进的推理框架.

类似于这样的CoT包括但不限于:

- 一步步思考(Let’s think step by step)

- 解释自己给出结论的理由(Answer by starting with analysis)

- 情绪勒索, 比如: 这项工作对我真的很重要(This is very important to my career)

- 跟模型说清楚要做什么, 而不是提出各种否定的要求.

- 奖励与威胁, 比如跟模型说: 做的好有奖励, 做的坏有惩罚(I’m going to tip $xxx for a better solution / you’ll be penalized if you get a wrong answer.)

没错这么说居然真的有用

当然, 还有一些被验证过无效的沟通方式, 比如:

- 对模型过度礼貌, 比如: 请你…(Please …)

这一大堆奇妙的输入是怎么被找到的? 目前的一种主流方式是使用 增强式学习(RL, Reinforcement Learning) 来进行. 这个概念我们上一章提到过, 这里就不赘述了.

2.2 提供额外信息

除了所谓的 特殊Prompt 之外, 其实往往更加有效的方式, 是对模型 耐心一些 .

事实上, 如今的大模型能力对于普通编程以及方案实现是完全足够的(这里特指如Gemini 3 Pro, GPT 5.1这一类最新的闭源模型), 而它的效果不佳的情况往往是提问者没有给出足够的限定条件.

说清楚要求, 提供具体示例, 往往能获得比加入特数Prompt更佳的效果. 事实上, 在很久之前, 这种方式就有个高级的名字, 叫 In-context learning .

2.3 你来做 “总工程师”

我们必须要承认, 即便如今, 语言模型仍然会自己犯一些无可避免的小错误, 这会使得整个任务都最终失败掉. 而事实上, 很多情况下, 是我们给了它 “过于复杂的任务” .

一个很好的方式是我们自行将任务拆解, 当我们将一个大任务拆解成一个个小任务的情况下, 语言模型的犯错几率会大大降低.

此时, 如果语言模型仍然犯错了, 怎么办?

语言模型有些时候是具备自我反省能力的!

大部分情况下, 当语言模型出错时, 你只需要重新重申你的要求, 再发一次你的请求, 并强调让其反思此前的内容. 它有很大几率能够自己找到错误在哪.

2.4 让语言模型使用工具

目前, 多数成熟的语言模型都具备了自行使用工具的能力, 包括但不限于图片识别, 联网搜索, 本地数据检索生成(RAG, Retrieval Augmented Generation), 自行写代码等等.

当然, 现在这不是问题了, ai都会自动调用工具.

2.5 让合适的模型做合适的事情

不同的模型擅长的领域并不一致.

就连当前最先进模型之一的GPT, 都要对其5.1版本单独出codex等等的细分版本, 这足以证明模型往往并不能做到擅长全部的事情, 而我们应当做的往往是挑出它的长板.

来自23年的一篇文章显示出, 当不同的模型协作并互相交流时, 推翻对方观点的可能性要比自行思考高出许多.

因此, 我们可以做的, 是让不同的模型扮演不同的角色, 并给它们对应的提示词, 让它们之间互相讨论, 从而能够实现更低的错误率以及更高的输出结果.

这篇博文比较短, 主要是一些通识性质的, 怎么让语言模型生成效果更佳的解释.

这篇博文就到这里~